Container managen mit Kubernetes

Agile Softwareentwicklung, komplexe Anwendungen und schnell veränderliche Marktbedingungen sind für Unternehmen, Softwareentwickler und IT-Infrastruktur-Betreiber eine ständig wachsende Herausforderung und machen eine flexiblere Art der Softwareentwicklung und des IT-Betriebs notwendig – weg von monolithischen Gesamt-Systemen, hin zu kleinen containerisierten Anwendungen oder Micro-Services. Für die optimale Verwaltung dieser kleinen Container-Einheiten setzt ONTEC unter anderem auf die Open-Source-Plattform Kubernetes.

Was ist Kubernetes?

Kubernetes ist ein Open-Source-Projekt der Cloud Native Computing Foundation. Das ursprünglich von Google entworfene Open-Source-System dient der Automatisierung, der Bereitstellung, Skalierung und Verwaltung von Container-Anwendungen.

Mit dieser Container-Orchestrierungs-Lösung lassen sich komplexe Softwaresysteme ressourcenschonend betreiben, warten und updaten, ohne den laufenden Betrieb zu stören. Kubernetes tut dies teilweise automatisiert und komplett unabhängig vom Betriebssystem.

Es ermöglicht die Mobilität zwischen verschiedenen Infrastrukturanbietern indem es die Computer-, Netzwerk- und Speicherinfrastruktur im Namen der Benutzer-Workloads koordiniert und dadurch die Einfachheit von PaaS (Platform as a Service) mit der Flexibilität von IaaS (Infrastructure as a Service) vereint.

Vorteile und Nutzen von Kubernetes für Unternehmen

Kubernetes bietet zahlreiche Vorteile für Unternehmen. Einige der bedeutendsten sind:

Mehr Stabilität und erhöhte Verfügbarkeit

Durch den hohen Grad an Automatisierung sorgt Kubernetes für einen geringen Aufwand beim Incident-Management. Fehler werden rasch ausfindig gemacht und können so schneller behoben werden. Die integrierten Self-Healing-Funktionen tragen das Ihre zur Stabilität und stabilen Verfügbarkeit des Systems bei.

Beschleunigte Bereitstellung neuer Releases

Kubernetes ermöglicht mit seiner Container-Struktur einheitliche Entwicklungs-, Test- und Live-Umgebungen. Dies hilft dabei, das Deployment zu automatisieren und dadurch die Time-to-Market (Dauer von der Entwicklung eines Produktes bis zur Produkteinführung und -platzierung auf dem Markt) zu verringern.

Flexibles Cloud-Computing durch Profitabilität und Multi-Cloud-Fähigkeit

Mit Kubernetes funktionieren Anwendungen weitestgehend unabhängig von der jeweiligen Umgebung. Es lassen sich selbst Multi-Cloud-Konzepte, in denen Applikationen auf unterschiedlichen Cloud-Plattformen betrieben werden, umsetzen, ohne die Funktionalität zu beeinträchtigen.

Weniger Aufwand - geringere Kosten

Durch Kubernetes können Personal- und Infrastrukturkosten deutlich gesenkt werden. Möglich wird dies durch die optimale Packungsdichte der diversen containerbasierten Applikationen und die dadurch effizientere Nutzung der vorhandenen Ressourcen sowie die Möglichkeit, Komponenten der Infrastruktur wiederzuverwenden.

Anwendung und Vorteile von Kubernetes für Softwareentwickler und IT-Infrastruktur-Betreiber

Agilität

Die Container-Orchestrierung mit Kubernetes ermöglicht die einfache Verschiebung von Containern von einer Stufe zu einer anderen bei gleichzeitiger Automatisierung vieler Arbeitsschritte. Das unterstützt die Zyklen von Development, Testing und Deployment insbesondere in agilen Softwareentwicklungsprojekten.

Flexible Infrastruktur

Egal, ob physische Server oder Cloud, Kubernetes kann in jeder Infrastruktur eingesetzt werden und lässt auch die Verknüpfung über verschiedene Plattformen hinweg (z. B. Hybrid Cloud) zu. Dadurch lässt sich die Ressourcennutzung noch besser optimieren.

Betriebssystemunabhängig

Da ein Container alle Softwarevoraussetzungen beinhaltet, die für eine Anwendung/ein Microservice notwendig sind ist er auch auf anderen Kubernetes-Nodes lauffähig, unabhängig vom Betriebssystem. Daher muss das Zielsystem nicht extra im Vorfeld angepasst werden.

Integriertes Monitoring

Das Monitoring der Applikationen und der Metriken ist in Kubernetes bereits integriert und kann von der Plattform auch automatisiert zur Optimierung herangezogen werden.

Skalierbarkeit

Kubernetes kann mithilfe der Autoscaling-Funktion die vorhandenen Ressourcen optimal ausnutzen und sicherstellen, dass nur verbraucht wird, was auch tatsächlich benötigt wird. In Verbindung mit externen Cloud-Speichern kann das System so dabei helfen, Kosten zu sparen. Außerdem können Auslastungsspitzen schnell und effizient ausgeglichen und das System so stets verfügbar gehalten werden.

Ausfallsicher

Einzelne Pods können sehr schnell dupliziert und in verteilten Systemen redundant verfügbar gemacht werden. Das macht Kubernetes zu einem sehr ausfallsicheren System und ideal für businesskritische Anwendungen.

Effizient

Durch kleinere Einheiten kann die Ressourcenverteilung von der Kubernetes-Plattform optimal angepasst werden. Zudem ergibt sich im Vergleich zu virtuellen Maschinen durch den Wegfall eines eigenen Betriebssystems für die einzelnen Container ein erheblich geringerer Ressourcenbedarf sowie eine Reduktion des Wartungsaufwands.

Übersichtliche Verwaltung

Große Anwendungen können durch Containerisierung in kleine Anwendungen (Micro-Services) zerlegt werden. Das macht die Gesamtlösung flexibler und einfacher zu warten und zu verwalten.

Kubernetes – Steuermann des virtuellen Containerschiffs

Kubernetes, dient als Orchestrierungs- und Management-Plattform, um selbst große Mengen an Containern zu verwalten. Es ist daher ein unverzichtbares Tool für den Aufbau stabiler DevOps-CI/CD-Pipelines. Durch den hohen Automatisierungsgrad des Systems werden manuelle Eingriffe minimiert und ein bestmögliches Funktionieren der verwalteten Container sichergestellt. Unter Berücksichtigung der verfügbaren Ressourcen und des Ressourcenbedarfs verteilt Kubernetes automatisiert die Workloads auf die zur Verfügung stehenden Nodes und sichert den laufenden Betrieb durch automatische Skalierung im Fall von Lastspitzen.

Das Kubernetes-Projekt – die Evolution des Betriebs komplexer Software-Systeme

Traditionelles System

Klassisch wurden Softwaresysteme auf physischen Servern betrieben. Betrieb man mehrere Software-Anwendungen auf einem Server, konnte das dazu führen, dass eine einzelne Applikation den größten Anteil der zur Verfügung stehenden Ressourcen beanspruchte, wodurch die anderen Anwendungen nicht mehr mit der notwendigen Leistung arbeiten konnten. Die offensichtliche Lösung, nämlich alle Software-Applikationen auf eigenen Servern laufen zu lassen, ist sehr teuer und schlecht skalierbar. Die Anwendungen selbst basierten auf einer monolithischen Architektur. Einzelne Teile des Systems konnten daher nur mit erheblichem Aufwand modifiziert werden, wodurch es weder wart- noch erweiterbar war.

Virtuelle Maschinen

Durch Virtualisierung der Hardware konnten Teile der Probleme traditioneller Systeme gelöst werden. Dabei laufen mehrere virtuelle Maschinen auf einem physischen Server, was die Skalierbarkeit und die Ressourcennutzung des Servers verbessert. Die Isolation der einzelnen Anwendungen zwischen den VMs erhöht zudem die Sicherheit. Eine einzelne Anwendung kann einfach hinzugefügt oder verändert werden, ohne das Risiko von Ausfallzeiten für das gesamte System und ohne neue Hardware anschaffen zu müssen. Nachteilig ist allerdings, dass in der VM ein eigenes Betriebssystem und eine eigene Library für jede Anwendung läuft, die bei Updates und Upgrades einzeln gewartet werden müssen.

Container-

Virtualisierung

Aus den modernen Anforderungen der Softwareentwicklung und des IT-Betriebs entstand die Idee der Containervirtualisierung. Dabei laufen statt virtueller Maschinen kleine Container (z. B. Docker-Container), die nur die Anwendung und die benötigte Library beinhalten und sich die Ressourcen des Betriebssystems teilen. Benötigt eine Anwendung mehr Ressourcen, kann einfach ein identischer Container gestartet werden. Die Aufteilung einer großen Anwendung in einzelne kleinere Applikation vereinfacht die Wartung und Anpassung des Gesamtsystems erheblich und ermöglicht einen optimierten Einsatz der verfügbaren Ressourcen.

Sie haben Fragen zu Kubernetes im Speziellen oder Containersteuerung, Containerisierung und Virtualisierung im Allgemeinen? Wir beantworten Ihnen diese gerne! Rufen Sie uns an, Sie werden es nicht bereuen.

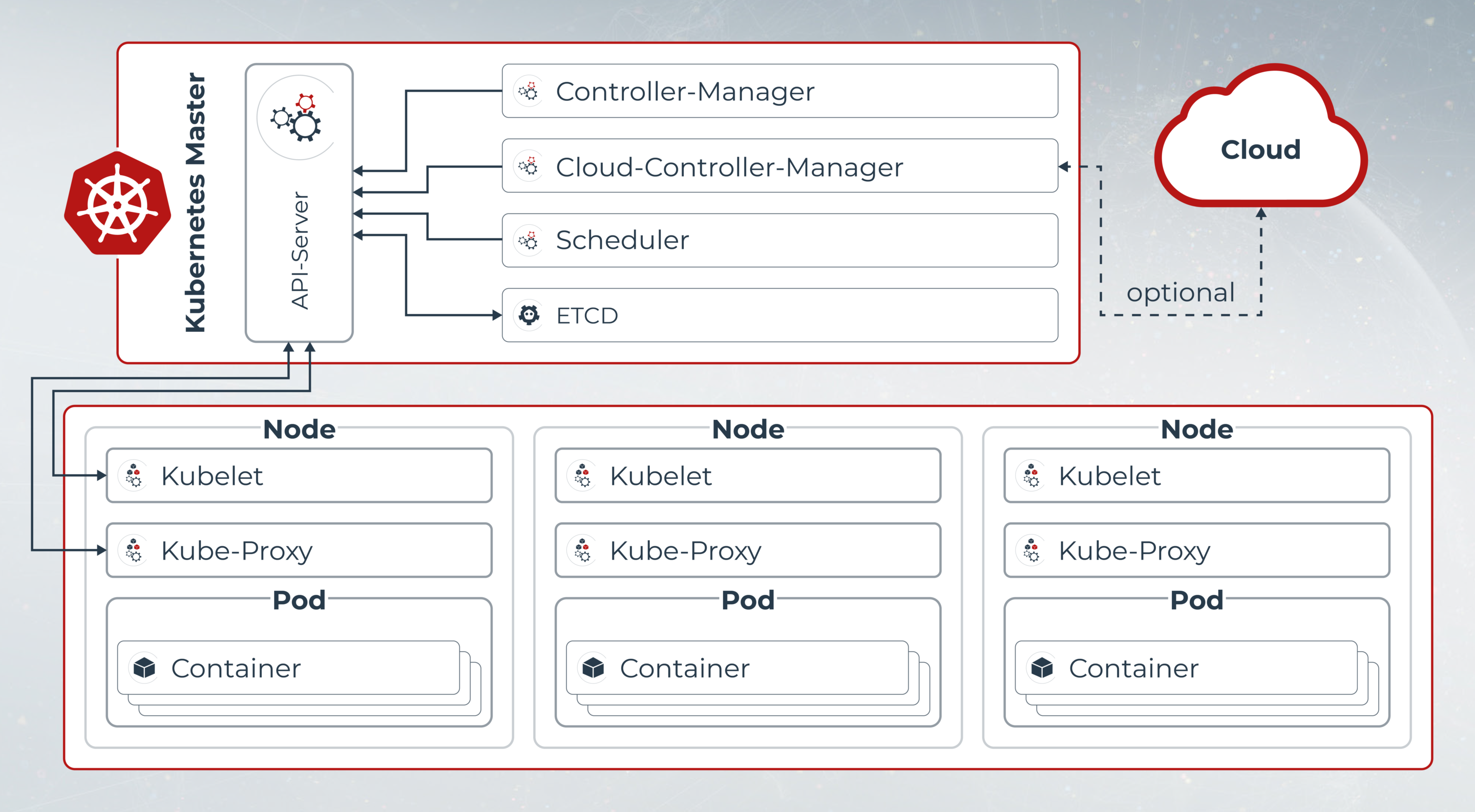

Aufbau der Kubernetes-Plattform

Kubernetes-Cluster

Der Cluster steht in der Kubernetes-Hierarchie an der höchsten Stelle und dient als zentrale Steuerungseinheit. In einem Cluster werden mehrere Worker-Nodes zusammengefasst, die über einen Master-Node verwaltet werden. Es sind somit mindestens 3 Nodes für einen funktionierenden Kubernetes-Cluster notwendig.

Node

Einer oder mehrere Pods laufen auf einem Node. Dieser kann sowohl eine physische als auch eine virtuelle Maschine sein und wird durch vCPU, RAM und Storage definiert.

Pod

Alle Container, die für eine bestimmte Anwendung zusammenarbeiten müssen, werden in einem Pod zusammengefasst. Ein Pod ist die kleinste in Kubernetes deploybare Einheit.

Container

Container sind die kleinsten Einheiten und beinhalten eine Anwendung oder Microservices und alle für ihren Betrieb notwendigen Softwareressourcen. Im Vergleich zu einer virtuellen Maschine benötigen sie kein eigenes Betriebssystem und sind somit ressourcenschonend und einfach zu verwalten.

Ihre ONTEC-Services für Kubernetes

Architekturberatung der Lösung

Installation / Konfiguration / Entstörungen

24/7 Betriebsführung der Kubernetes-Landschaft

On-Premise-Konfigurationen

Hyperscaler-Setups (AWS, Azure, Google, etc.)

DevOps Consulting / Best Practices

KONTAKT AUFNEHMEN

Hannes Gruber

ONTEC AG

Kundenorientierung bedeutet für mich sich in die Lage des Kunden versetzen zu können. Genaues Zuhören, verstehen und ein fachlich top aufgestelltes Team sind hierbei entscheidend, um den Kunden die optimale Lösung anzubieten.